使用 Python、XGBoost 和 BERT 建立即時 AI 詐騙防禦系統

詐騙不僅僅是一種麻煩;它是一個價值125億美元的產業。根據2024年FTC數據,報告的詐騙損失大幅增加,僅投資詐騙就佔了近一半的總額。

對於開發人員和系統架構師來說,挑戰是雙重的:

- 交易詐騙: 檢測結構化金融數據中的異常(誰匯款?去哪裡?多少錢?)。

- 通訊詐騙(垃圾郵件/釣魚): 在非結構化文本中檢測惡意意圖(SMS連結,電子郵件釣魚)。

傳統的基於規則的系統("如果金額 > 10,000美元,標記它")太脆弱。它們會產生誤報並錯過不斷演變的攻擊向量。

在這個工程指南中,我們將構建一個 雙層防禦系統。我們將實現一個高速的 XGBoost 模型用於交易監控,以及一個基於 BERT 的NLP引擎用於垃圾郵件檢測,並將所有這些包裝在雲原生微服務架構中。

讓我們開始構建。

架構:實時和雲原生

我們不是在構建一個過夜運行的批處理作業。詐騙發生在毫秒內。我們需要一個實時推理引擎。

我們的系統由兩個不同的管道組成,它們都輸入到一個中央決策引擎。

技術堆棧

- 語言: Python 3.9+

- 結構化學習: XGBoost(極端梯度提升)和 Random Forest。

- NLP: Hugging Face Transformers(BERT)和 Scikit-learn(樸素貝葉斯)。

- 部署: Docker、Kubernetes、FastAPI。

第1部分:交易防禦者(XGBoost)

在處理表格金融數據(金額、時間、位置、設備ID)時, XGBoost 目前是最佳選擇。在我們的基準測試中,它達到了 98.2%的準確率 和 97.6%的精確度,在速度和可靠性方面都優於Random Forest。

挑戰:不平衡數據

詐騙很少見。如果你有100,000筆交易,可能只有30筆是欺詐性的。如果你用這個訓練模型,它只會每次都猜"合法",並達到99.9%的準確率,同時錯過每一個詐騙案例。

解決方案: 我們使用 SMOTE (合成少數過採樣技術)或在訓練期間進行類別權重調整。

實施藍圖

以下是如何設置XGBoost分類器進行交易評分。

import xgboost as xgb from sklearn.model_selection import train_test_split from sklearn.metrics import precision_score, recall_score, f1_score import pandas as pd # 1. Load Data (Anonymized Transaction Logs) # Features: Amount, OldBalance, NewBalance, Location_ID, Device_ID, TimeDelta df = pd.read_csv('transactions.csv') X = df.drop(['isFraud'], axis=1) y = df['isFraud'] # 2. Split Data X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 3. Initialize XGBoost # scale_pos_weight is crucial for imbalanced fraud data model = xgb.XGBClassifier( objective='binary:logistic', n_estimators=100, learning_rate=0.1, max_depth=5, scale_pos_weight=10, # Handling class imbalance use_label_encoder=False ) # 4. Train print("Training Fraud Detection Model...") model.fit(X_train, y_train) # 5. Evaluate preds = model.predict(X_test) print(f"Precision: {precision_score(y_test, preds):.4f}") print(f"Recall: {recall_score(y_test, preds):.4f}") print(f"F1 Score: {f1_score(y_test, preds):.4f}")

為什麼XGBoost勝出:

- 速度: 它處理表格數據的速度明顯快於深度神經網絡。

- 稀疏性: 它優雅地處理缺失值(在設備指紋識別中很常見)。

- 可解釋性: 與"黑盒"神經網絡不同,我們可以輸出特徵重要性來解釋 為什麼 交易被阻止。

第2部分:垃圾郵件獵手(NLP)

詐騙通常從一個連結開始。"點擊此處更新您的KYC。" \n 要檢測這一點,我們需要自然語言處理(NLP)。

我們比較了 樸素貝葉斯 (輕量級,快速)與 BERT (深度學習)。

- 樸素貝葉斯: 94.1%準確率。適用於簡單的關鍵詞堆砌垃圾郵件。

- BERT: 98.9%準確率。對於"上下文"釣魚必不可少(例如,看起來不像垃圾郵件的社會工程電子郵件)。

實施藍圖(BERT)

對於生產環境,我們微調一個預訓練的Transformer模型。

from transformers import BertTokenizer, BertForSequenceClassification import torch # 1. Load Pre-trained BERT model_name = "bert-base-uncased" tokenizer = BertTokenizer.from_pretrained(model_name) model = BertForSequenceClassification.from_pretrained(model_name, num_labels=2) def classify_message(text): # 2. Tokenize Input inputs = tokenizer( text, return_tensors="pt", truncation=True, padding=True, max_length=512 ) # 3. Inference with torch.no_grad(): outputs = model(**inputs) # 4. Convert Logits to Probability probabilities = torch.nn.functional.softmax(outputs.logits, dim=-1) spam_score = probabilities[0][1].item() # Score for 'Label 1' (Spam) return spam_score # Usage msg = "Urgent! Your account is locked. Click http://bad-link.com" score = classify_message(msg) if score > 0.9: print(f"BLOCKED: Phishing Detected (Confidence: {score:.2%})")

第3部分:"硬停止"工作流程

檢測如果沒有行動是沒有用的。這個架構最創新的部分是 干預邏輯。

我們不僅僅記錄詐騙;我們攔截用戶旅程。

工作流程:

- 用戶收到SMS: "更新支付方式。"

- 用戶點擊: 點擊通過我們的微服務路由。

- 實時掃描: URL和消息內容由BERT模型評分。

- 決策點:

- 安全: 用戶被重定向到實際的支付網關。

- 詐騙: 彈出"硬停止"警報。

注意: 與將項目移至垃圾郵件文件夾的標準電子郵件過濾器不同,此系統位於點擊和目的地之間,防止用戶加載惡意負載。

關鍵指標

當部署到生產環境時,"準確率"是一個虛榮指標。你需要關注 精確度 和 召回率。

- 誤報(精確度下降): 你阻止了一個合法用戶購買咖啡。他們生氣並停止使用你的應用。

- 漏報(召回率下降): 你讓黑客耗盡一個帳戶。你損失金錢和聲譽。

在我們的研究中, XGBoost 提供了最佳平衡:

- 準確率: 98.2%

- 召回率: 95.3%(它捕獲了95%的所有詐騙)。

- 延遲: 適合實時阻止的快速推理。

結論

手動詐騙審查的時代已經結束。隨著交易量的爆炸性增長,唯一可擴展的防禦是AI。

通過結合 XGBoost 處理結構化交易數據和 BERT 處理非結構化通信數據,我們創建了一個強大的盾牌,不僅保護用戶免受財務損失,還能防範先前的社會工程。

開發人員的下一步:

- 容器化: 將上述Python腳本包裝在Docker中。

- 暴露API: 使用FastAPI創建一個 /predict 端點。

- 部署: 推送到Kubernetes(EKS/GKE)以獲得自動擴展能力。

\ \

您可能也會喜歡

東京地鐵、都營地鐵一日票、及海外旅客24小時、48小時與72小時套票將支援手機QR Code數位車票

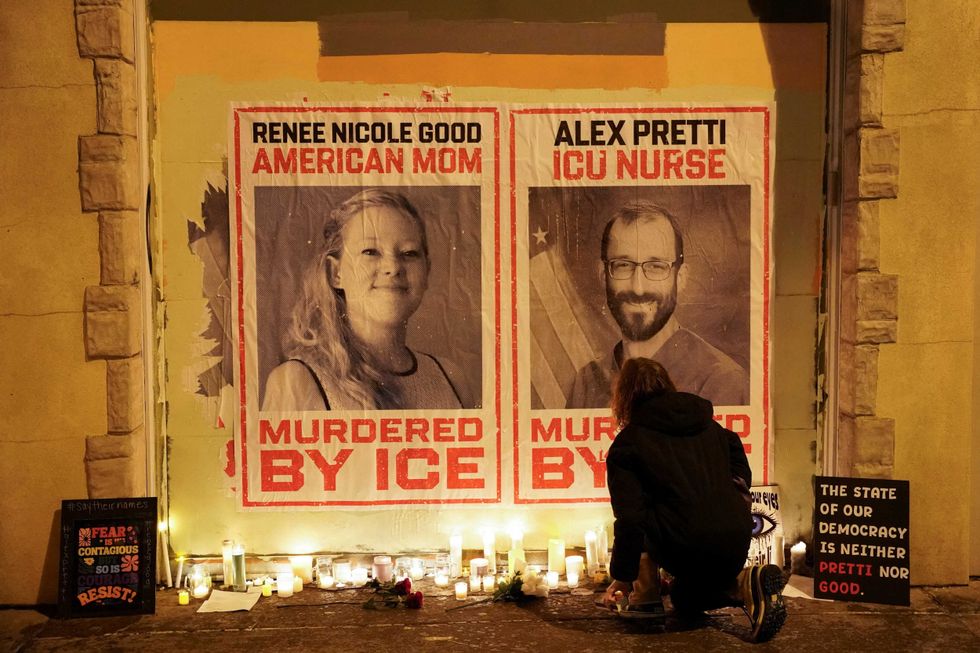

即決處決:這項法律理論能為ICE槍擊受害者帶來正義的希望嗎?