微軟推出自家設計的晶片 Maia 200,採用台積電 3nm 製程,據稱在 AI 訓練與推論效能上超越 Google TPU 與 AWS Trainium,強化自身雲端運算競爭力。

在自製晶片戰場急起直追的微軟,於美東時間26日正式推出其第二代自製AI晶片Maia 200。這款採用台積電3nm製程晶片 (並非如先前傳聞將採Intel製程技術),號稱是微軟有史以來最高效的推理系統,不僅在每美元效能比前代設計提升30%,更在特定指標上直接點名超越Google TPU與亞馬遜的Trainium。

Maia 200規格解析:專為大規模模型而生

Maia 200的規格相當強悍,單顆晶片塞入超過1400億個電晶體。針對AI推理最看重的算力,官方數據顯示:

• FP4精度:提供超過10 petaFLOPS算力。

• FP8精度:提供超過5 petaFLOPS算力。

• 功耗:控制在750W以內。

• 記憶體:配備216GB HBM3e高頻寬記憶體,資料傳輸頻寬高達7 TB/s。

微軟雲端與AI負責人Scott Guthrie強調,Maia 200不僅能輕鬆運行當今最大的模型,更為未來的超大型模型預留了空間。

直接對標競品:超越Google與亞馬遜

微軟這次毫不客氣地將矛頭對準了雲端市場的兩大對手,分別為Google與亞馬遜。根據Scott Guthrie的說法,Maia 200在FP4精度下的運算性能是亞馬遜Trainium 3的三倍,而在FP8精度下則超越Google第七代TPU「Ironwood」。

這款晶片目前已經開始佈署至微軟位於愛荷華州的資料中心,首波應用將鎖定微軟內部的超級智慧團隊 (Superintelligence Team),用於生成合成數據,藉此訓練下一代AI模型,同時也將支援Copilot服務,以及OpenAI GPT-5.2等重量級模型運作。

戰略意義:減少對NVIDIA的依賴

Maia 200的推出,最核心的戰略意義在於「自主權」。在NVIDIA GPU供不應求且價格高昂的現況下,微軟透過自製晶片,不僅能降低硬體成本,更能針對自家的Azure 雲端架構進行運算最佳化。

Maia 200捨棄了NVIDIA主導的InfiniBand,改採標準乙太網路 (Ethernet) 進行互連,這也顯示了微軟試圖打破NVIDIA生態壟斷的決心。

微軟目前已向特定開發者開放Maia 200的軟體開發工具包 (SDK)預覽版,並計畫未來向更多Azure客戶開放租用。此外,下一代Maia 300也已在設計中,展現了微軟在晶片領域長期抗戰的意志。

分析觀點

微軟這波操作可說是「蓄力已久」。相比於Google早早就投入TPU研發,微軟在自研晶片這條路上起步較晚,但透過與OpenAI的緊密合作,微軟非常清楚「跑GPT模型到底需要什麼樣的晶片」。

Maia 200的規格與定位非常精準:它不是要完全取代NVIDIA H100/H200在「訓練」 (Training)端的統治地位,而是要在需求量更龐大的「推理」 (Inference)端搶下市佔。特別是當Copilot這類服務需要數以億計的用戶同時在線時,用昂貴的NVIDIA GPU來做推理實在太奢侈,這時Maia 200的「每美元效能」優勢就會凸顯出來。

此外,採用台積電3nm製程也顯示微軟這次是玩真的,願意下重本在先進製程上。對NVIDIA來說,雖然短期內高階訓練卡地位難以撼動,但隨著雲端三巨頭 (AWS、Google、微軟)的自研晶片效能越來越強,未來在推理市場的份額勢必會被逐步侵蝕。

資料來源

- https://mashdigi.com/microsoft-unveils-its-self-developed-chip-the-maia-200-3nm-process-performance-surpassing-google-tpu-and-aws-trainium/

您可能也會喜歡

Vitalik:拒絕Crypto末日劇本,做對抗AI極權的最後防線

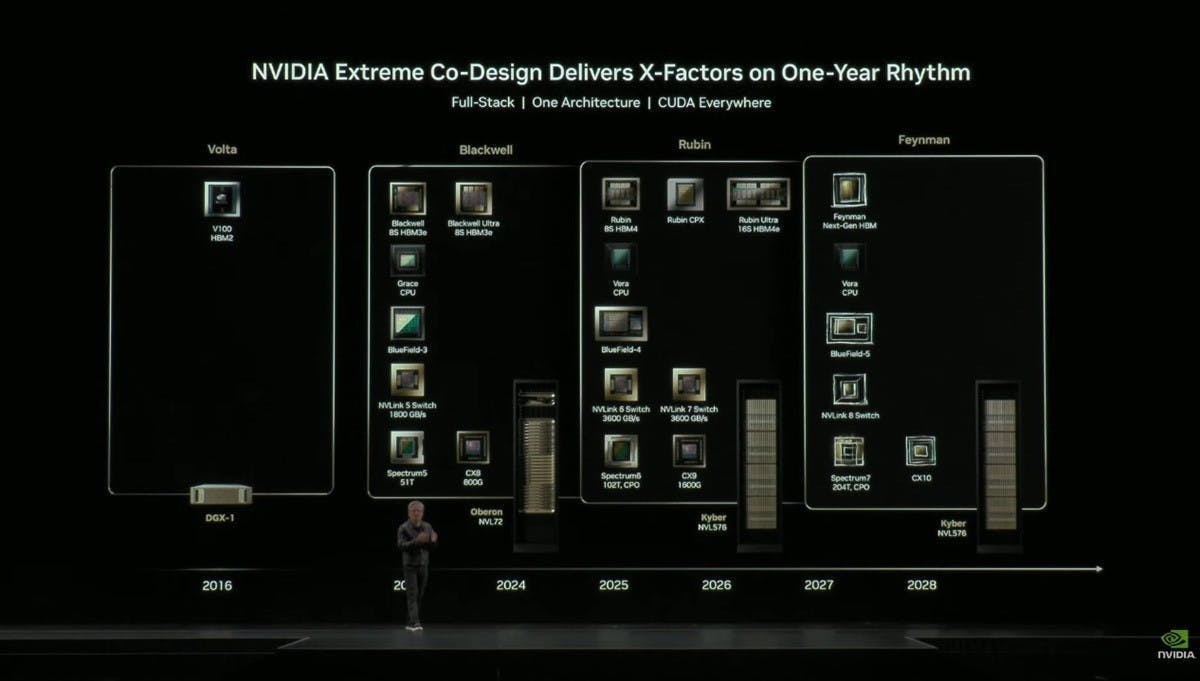

傳NVIDIA Feynman平台IO Die將委由Intel代工,但關鍵GPU Die仍由台積電製造